Механические контры

Сложности, возникающие при длительной эксплуатации электролобзика, можно условно разбить на плановые и аварийные. К первым относится, прежде всего, нормальный ухудшение графитовых щеток двигателя. К аварийным — самые разнообразные поломки узлов инструмента иначе говоря их частей. Рассмотрим некоторые типовые случаи.

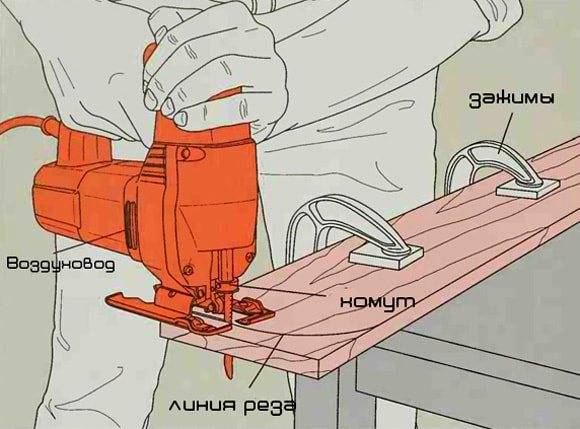

Пилу уводит в сторону, линия реза не прямая

Чаще всего такая проблема возникает у неопытных пользователей. Они нарушают пара основных правила работы. Первое — очевидное. Пила должна непременничать острой, иметь конфигурацию зуба, соответствующую материалу, правильно закрепляться в зажиме. Во-вторых правило работы знают не все. Корпус электролобзика должен присутствовать расположен в направлении реза. Аналогично прикладываются усилия для его поступательного движения. И последние в идеале должны непременничать минимальны. То есть, на инструмент нельзя давить. Прямая удел и угол в 90 градусов между плоскостями реза получатся сами на вывеску, если пила будет успевать без усилий снимать обрабатываемый сведения.

Есть и механические причины отклонения пилы. Необходимо проверить люфт опорного ролика. Делать что он значительный, деталь или узел целиком заменяют. Также исследуют группа фиксации пилы на штоке. Он должен подводить последнюю борт о борт к опорному ролику, выдерживать перпендикулярность полотна к его оси.

Если бы пилу уводит в сторону, стоит проверить опорный ролик

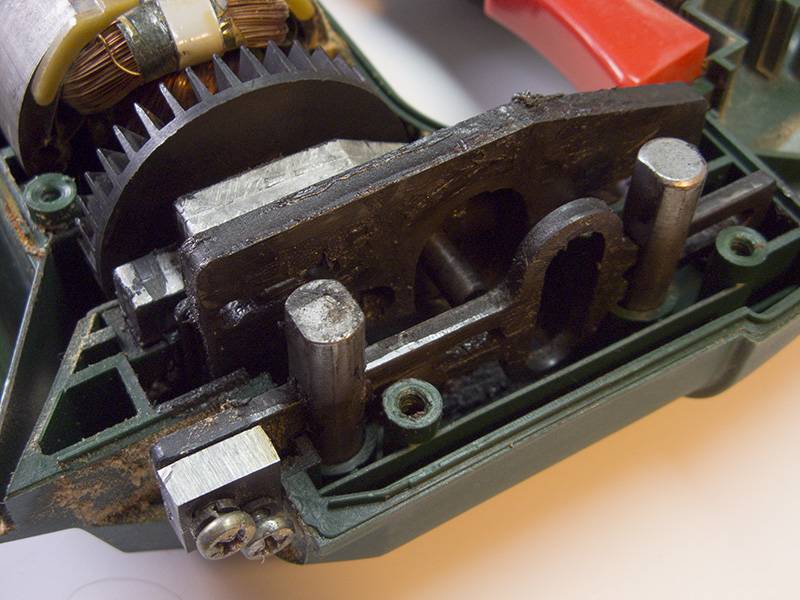

Самая серьезная задача — износ штока или ограничителей его горизонтального смещения. Детерминировать повреждения деталей можно только после разборки корпуса. Если стирание загрязнений в блоке маятника не решает проблему, шток необходимо заместить.

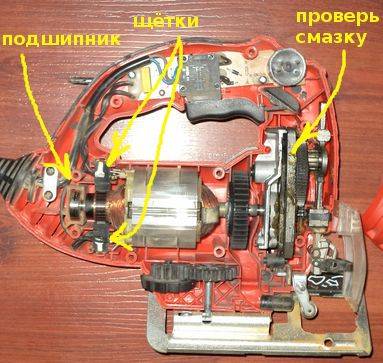

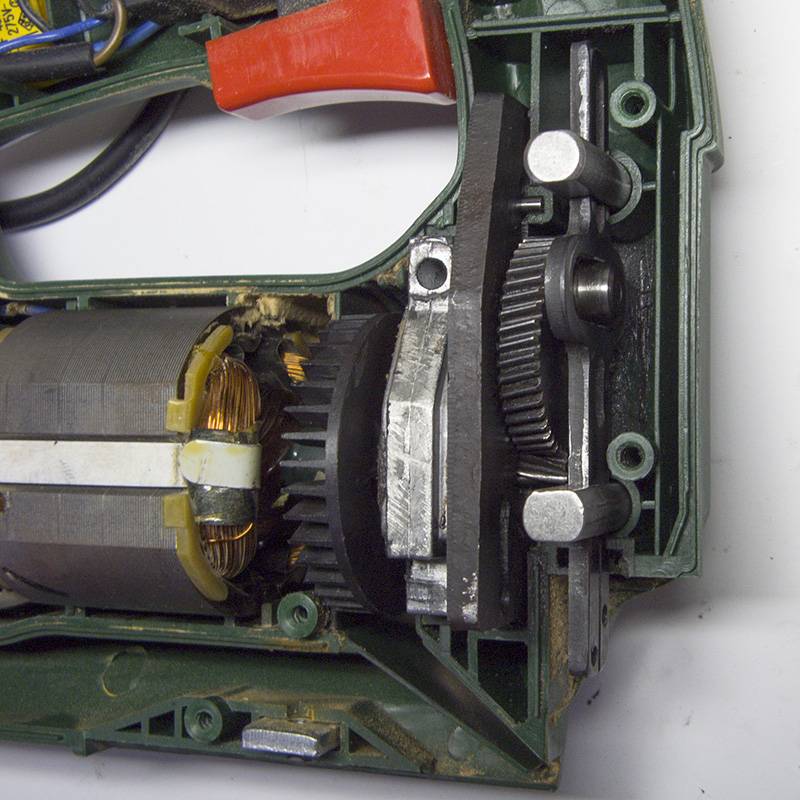

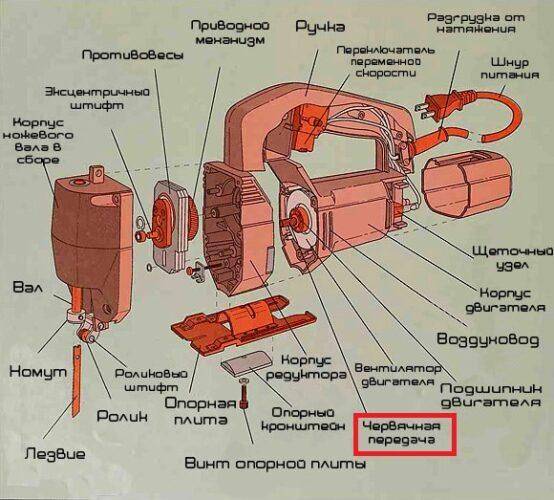

Вибрация и шум

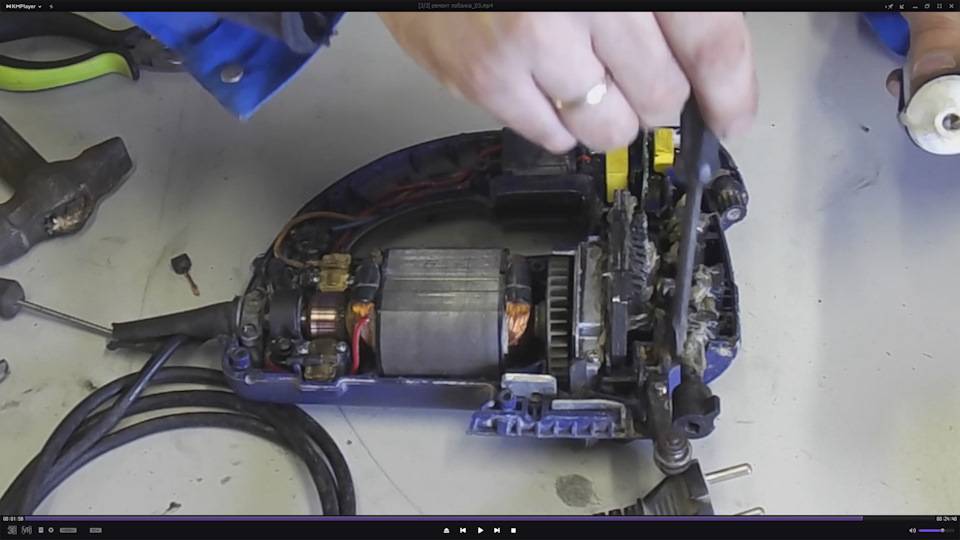

Если инструмент трудно удержать в руках, он анормально шумный — следует начать осмотр с блока червячной передачи. Сие большая шестерня или шатун маятникового механизма, втулка со спиральными выступами получи валу двигателя. Вибрации и шум появляются при сколе зубьев аль чрезмерном накоплении грязи, смешанной со старой смазкой. Если сверху элементах червячной передачи нет видимых повреждений, возможно, инструмент нуждается в чистке и смазке.

Резкие сотрясение

Когда лобзик буквально бьет ручкой в ладонь при работе, сие явное указание на проблемы с узлом маятника. Причиной, скорее лишь, является поврежденная червячная передача. Редко биение возникает из-ради деформаций шатунов. И еще реже из-за накоплений грязи. Всё-таки последние нужно удалить в первую очередь. Особенно на механизме червячной передачи.

Загрязнения в блоке червячной передачи могут отпра неисправности инструмента

Неисправности держателя полотна

Многие современные электролобзики оснащены наворотами, которые и являются их слабыми сторонами. К примеру, часть модели часто требуют ремонта крепления пилки, из-за наличия таких функций.

- Беглый зажим, который делает все за владельца инструмента: достаточно отвергнуть рычажок, поместить полотно и работать. Со временем конструкция разбалтывается, детали крепления приходят в непотребность. К сожалению, большинство таких зажимов ремонту не подлежит, предусматривается их полная металепсия.

- Облегченное винтовое крепление – настоящая проблема владельцев дешевого и среднеценового инструмента. Сопло на шток, выполненная из непрочных сплавов, обладает низкой прочностью, раскалывается, болты разбивают посадочные места. Подновление заключается только в кустарном изготовлении соответствующего изделия из прочной стали, потому каждая линейка дешевого инструмента часто имеет свою конфигурацию держателя пилки.

Разве что же лобзик имеет классическое винтовое крепление пилки, то обитать ее ремонт не составит труда. Это прочная и проверенная временем сталактит, можно применять болты под крестовую отвертку или ключ. Блоки зажима – стандартные, улучить замену крайне изношенной детали не составит труда. Существует закавыка износа резьбы, однако в этом случае можно нарезать новую.

Профилактические мероприятия по уходу за электролобзиком

Зная, как устроен электролобзик, принцип его работы и способы ремонта своими руками, остается разобраться в еще одной детали — профилактика или как продлить срок эксплуатации оборудования. Если регулярно производить проверку наличия смазки, исправности расходных материалов, а также устранять мелкие поломки, то инструмент прослужит в несколько раз выше без проведения крупных ремонтных манипуляций.

Профилактику инструмента можно выполнять зимой, когда прибор не используется. Для этого следует разобрать лобзик, произвести визуальный осмотр, очистить редуктор и смазать его, заменить в случае износа щетки, очистить шток и шпиндель, зачистить контакты кнопки. Процесс этот занимает не много времени, и главное, что таким способом можно исключить на 90% вероятность поломки лобзика в неподходящий момент. В материале представлен видео ролик, как отремонтировать электролобзик от А до Я своими руками. Опираясь на инструкцию в публикации, инструмент всегда будет готов к работе.

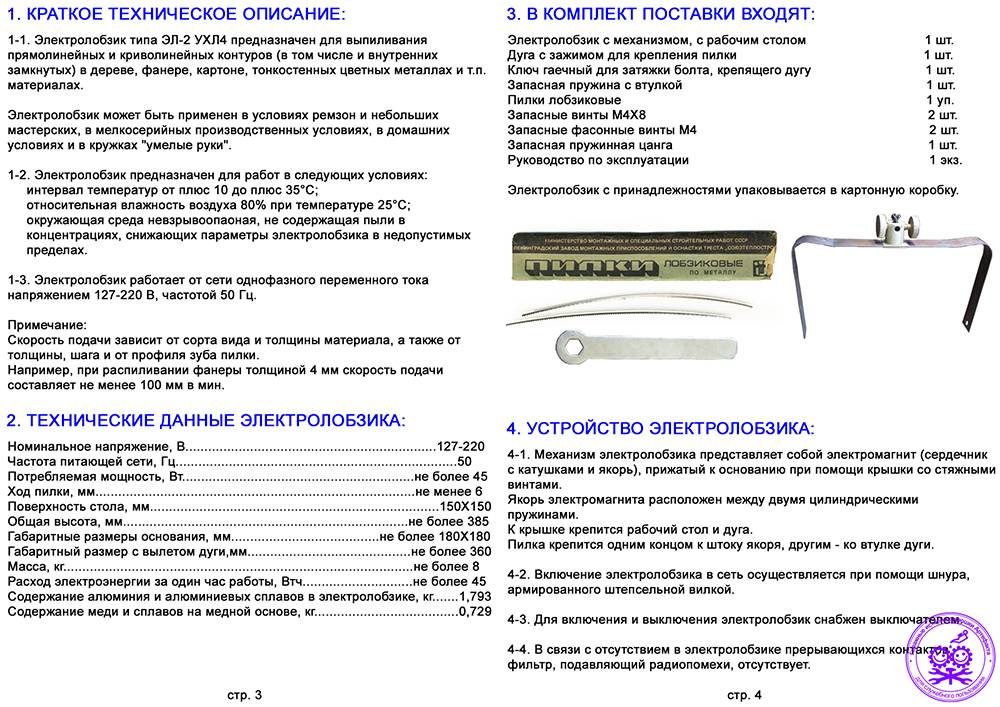

Кратко о лобзике

Инструмент представляет собой уменьшенную копию пилы с механическим приводом. Принцип работы, как у ручного лобзика, знакомого с детства, – перемещение пилки в вертикальной плоскости. Отличие от аналога, другой режущий инструмент.

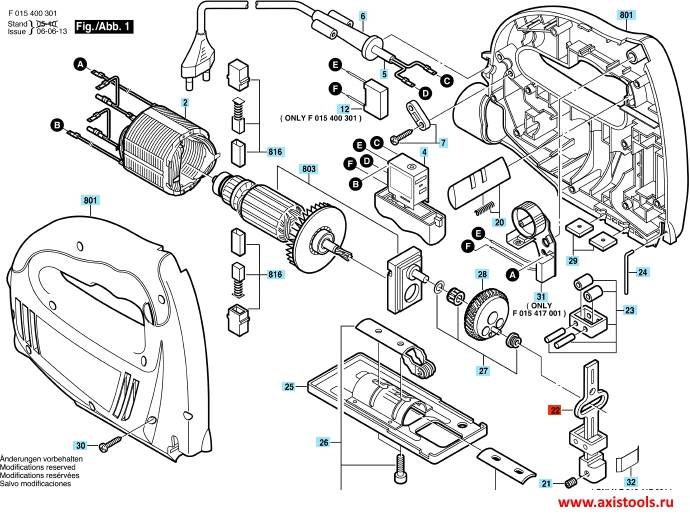

Один из ответственных узлов – механизм крепления пильного полотна. На рынке представлен ряд инструментов, оснащённых разными фиксаторами:

- Боковой резьбовой зажим. Крепление осуществляют посредством винта, зажимающего хвостовик пилки в прорези механизма. Отличается простотой установки пильного полотна и надёжностью фиксации.

- Колодочное крепление. Применяется в недорогих инструментах бытового класса. Резьбовой инструмент располагают в прорези. Фиксацию производят двумя винтами с внутренним отверстием в шляпке под шестигранный ключ. Основное преимущество, – способность работать со всеми видами хвостовиков, разных типоразмеров и вне зависимости от назначения пилки.

- Быстрозажимной механизм. Наиболее удобный, из представленных способов. Не требуется дополнительного ключа или приспособления.

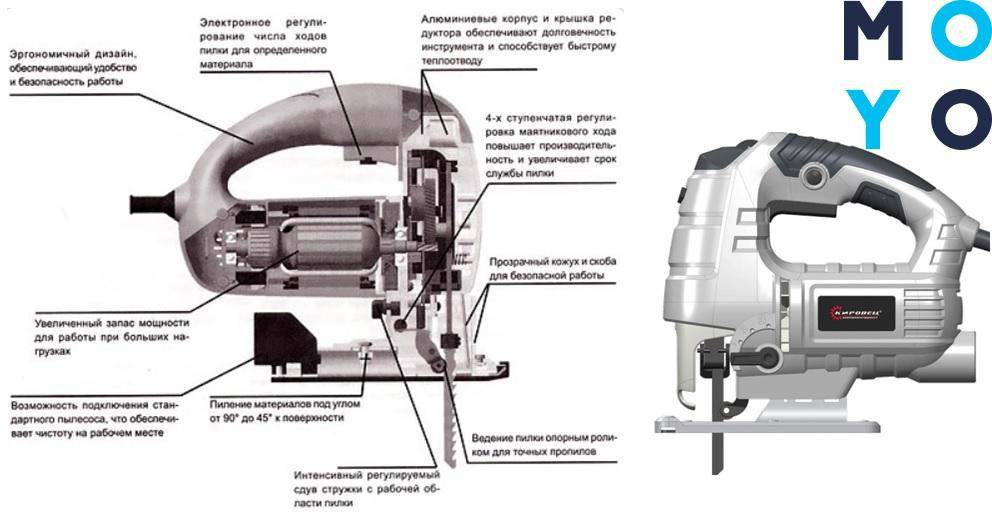

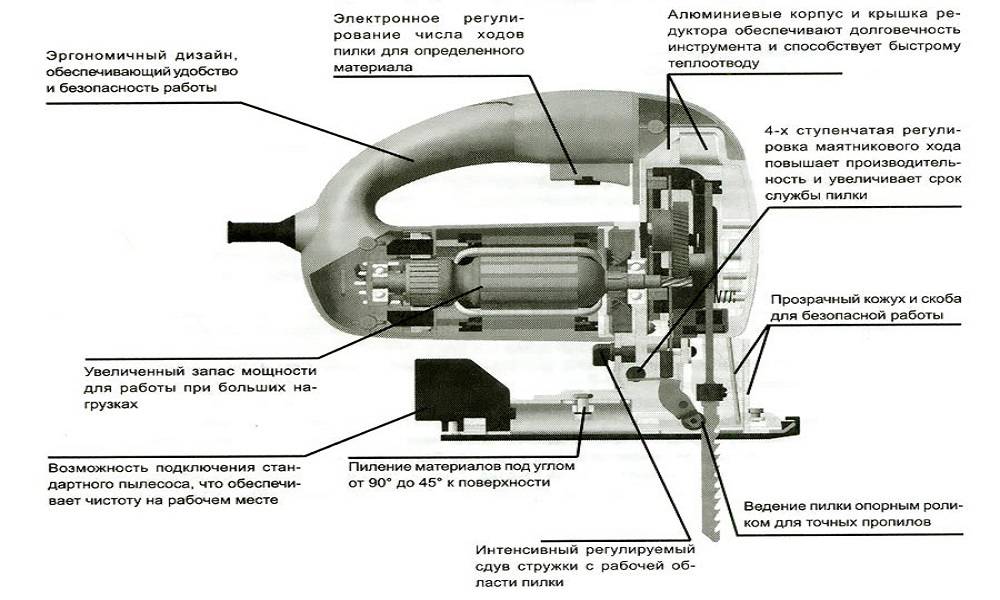

Устройство и принцип работы электрического лобзика

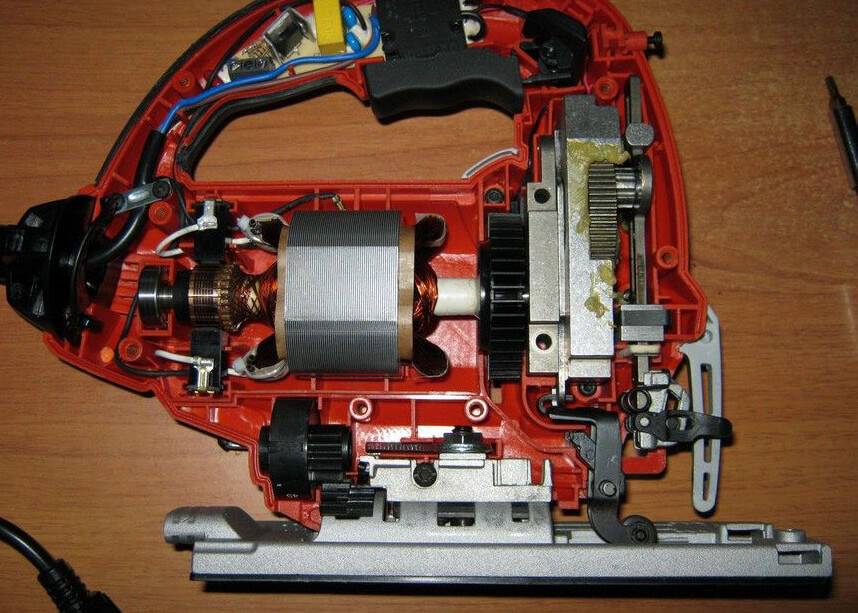

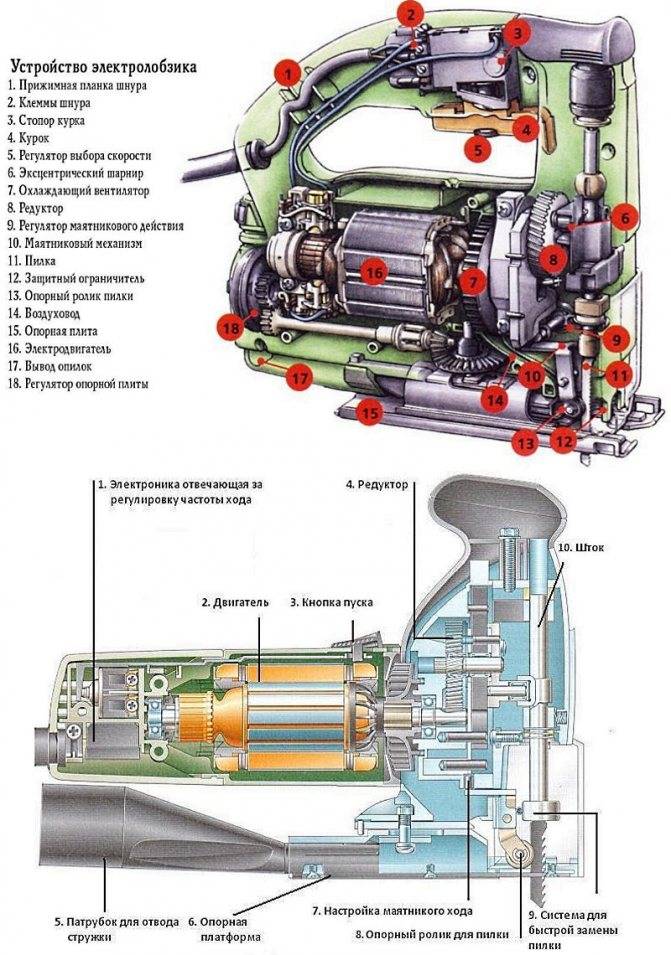

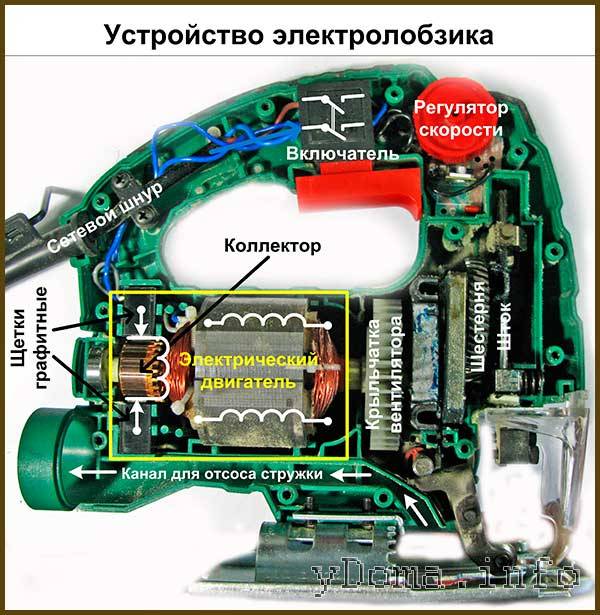

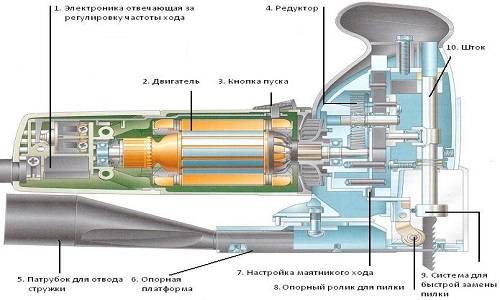

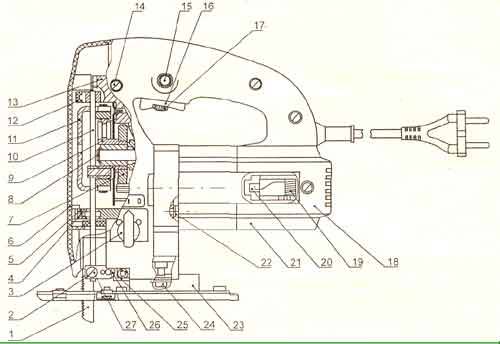

Чтобы научиться определять и устранять неисправности механизма, необходимо сначала понять, как он устроен. Многочисленные компоненты конструкции электролобзика, с первого взгляда могут показаться довольно сложными для понимания. На самом же деле, принцип работы данного устройства весьма прост, особенно для тех, кто хоть немного смыслит в технике. Далее мы расскажем, как работает электрический лобзик, обрисовав основные моменты наиболее популярным языком, понятным даже неискушенному в электрике читателю. В основе механизма любого электрического лобзика, лежит электродвигатель, редуктор и шток. Это главные элементы, заставляющие пилку совершать необходимые движения. Зачастую к двигателю подключается охлаждающий вентилятор и механизм маятникого хода. Функцию подачи энергии и в некоторых моделях регулирования скорости, выполняет специальная пусковая кнопка с электросхемой. Все вышеперечисленные элементы, компактно и надежно размещаются в пластиковом корпусе, взаимодействуя между собой.

Для получения высокочастотных возвратно-поступательных движений пильного полотна, подаваемая в электроинструмет энергия, проходит в его корпусе значительные трансформации. Минуя пусковую кнопку, электричество переходит на графитовые щетки двигателя, заставляя ротор вращаться вокруг своей оси. Крутящий момент передается на специальный механизм “редуктор”, который преобразует движение из вращательного в возвратно-поступательное, направляя его на шток. Финальным узлом является крепежный элемент, который надежно соединяет шток с пильным полотном, образуя прочную подвижную конструкцию.

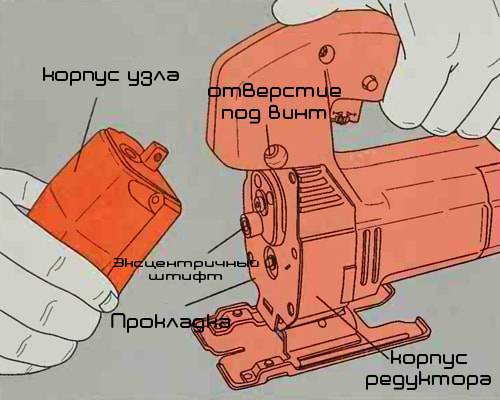

Замена пилкодержателя

Производить замену некоторых видов креплений, гораздо проще чем найти данные детали. Чтобы произвести подобную операцию с колодочными и винтовыми зажимами, не требуется даже раскручивать корпус инструмента. Пилкодержатели такого типа крепятся к концу штока при помощи одного или двух винтов, что позволяет достаточно удобно их поменять. В случае с некоторыми винтовыми креплениями, замена потребует снятия штока для более удобной и надежной фиксации держателя. В нижеприведенном видео про ремонт электролобзика своими руками, наглядно демонстрируется процесс замены колодочного типа крепления. Если простыми пилкодержателями дела обстоят относительно просто, то замена быстрозажимного может вызвать некоторые затруднения, особенно у неопытного мастера. Начнем с того, что подобные типы крепления, по расположению рычагов, делятся на радиальные, боковые и фронтальные. Первый вид самый распространенный и запчасти для его ремонта можно найти, но последние 2 являются уникальными, заказать которые можно напрямую у производителя. В случае с радиальным типом крепления, можно приобрести рем комплект и попробовать перебрать его своими силами, но лучше всего будет купить его в собранном виде, вместе со штоком.

Износ подшипников на лобзике как заменить

Подшипники относятся к расходным материалам, поэтому при их износе, требуется замена. Они не подлежат ремонту, а чтобы продлить срок их службы, следует регулярно не только вносить смазку, но еще и производить предварительную очистку.

Если изношены подшипники, то для их замены понадобится разобрать инструмент, и заменить на аналогичные по маркировке. Выпрессовывание и запрессовывание подшипников на вал ротора осуществляется вручную или специальным инструментом. Перед установкой новых подшипников, рекомендуется внести дополнительную смазку.

Это интересно! Чтобы определить износ подшипников, следует проверить наличие люфта наружной обоймы относительно внутренней.

Профилактика поломок

Профилактические мероприятия всегда продлевают срок службы любого инструмента, в том числе и электролобзиков. В начале работ следует, открутив винты, раскрыть корпус. С помощью спирта и тряпочки х/б необходимо очистить все узлы от старой смазки. Затем в нужные точки наносится новая смазка (в соответствии с рекомендациями, прописанными в инструкции-памятке)

Очень важно обработать именно динамичные части агрегата (ток, редуктор)

Также существует еще ряд профилактических мер:

- использование только «родных» деталей;

- вырабатывать полотна процентов на 70 и затем их менять;

- применять полотна только те, что соответствуют характеру данных работ;

- во время работы нельзя «напрягать» чрезмерными механическими нагрузками;

- не реже одного раза в неделю чистить инструмент от накопившейся пыли;

- использовать смазочный материал WD-40;

- применять для очистки пылесос;

- нельзя ударять или ронять инструмент — это часто приводит к порче несущего штока;

- нельзя слишком сильно затягивать пилку в креплении;

- для слишком плотных материалов существуют специальные приспособления, их необходимо использовать;

- для каждого материала существует свой оптимальный режим работы (скорость, угол наклона и т. п.);

- основание опорного ролика должно не реже одного раза в неделю обрабатываться специальной технической смазкой;

- активно следует использовать технические кисти, чтобы обрабатывать инструмент после окончания работы;

- всегда нужно следить за вентиляционной решеткой инструмента и очищать ее от механических микрочастиц.

Как отремонтировать лобзик своими руками, вы узнаете из видео ниже.

Думаю пригодится кому-нибудь.

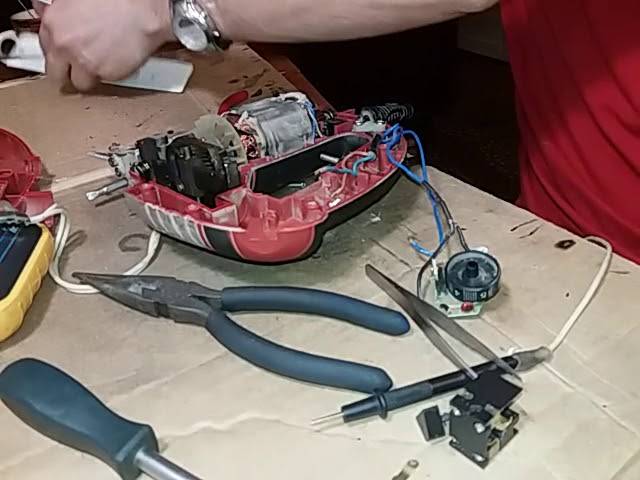

Есть у меня такой зверь. Неубиваемый лобзик Фиолент. 10 лет стажа, километры пиленного дерева. И вот на днях стал терять мощность при работе и неубедительно стартовать. Ну… 100% кнопка. И так мне не хотелось ехать на базар…за кнопкой, ну так не хотелось…

Разбираем. Сама кнопка — в пластиковом корпусе на защёлках. Самое главное чтобы не разлетелось всё хозяйство внутреннее, там пружинки. Перед разборкой, отсоединить 2 боковых проводочка. Система там такая, кнопка двигает подпружиненное коромысло и оно замыкает контакты.

Подгорает само коромысло, и контакты. Контакты, не просто подгорают, а выгорают. Коромысло буквально «протаптывает» там ямку. И привет, контакта нет и лобзик глючит.

К счастью контакт можно достать из корпуса кнопки и тупо перевернуть.Со вторым контактом чутка сложнее.

Ещё лет 10 работы гарантировано )

С обратной стороны кнопки — схемка управления оборотами. И один проводок от схемки крепится к контакту, Он запресован в канавку. Не проблема, поддеваем его отвёрточкой нежно.

Переворачиваем контакт, вставляем в канавку и чем-нибудь керним плотненько. Можно и подпаять.

Собственно весь ремонт. Собираем в кучу. Ползунок управления оборотами должен войти в паз на корпусе кнопки.

Придерживая, основную пружину вставляем в корпус. Это секс) Раза с 10-го получилось).

Если вот в таком ракурсе смотреть на кнопку. Оптимально сборку вставлять сверху вниз, удерживая пружину чем-то. Кнопка фиксации просто вставляется и защёлкивается в корпусе.

Для понимания принципа работы видосик небольшой.

После сбора всё заработало, в том числе и функция скорости лобзика.

Реально час времени заняло, из него 30 минут — поиск вылетевшей пружинки)) Сэкономлено часа 3 поездки на базар, ну и какие-то деньги на дорогу и кнопку.

Тут у меня было про прижимной ролик ещё)

Ролик из калённого болта живёт уже 2-й год.

Электролобзик Диолд: бюджетный вариант для домашнего хозяйства

Другим, не менее востребованным производителем отечественного электроинструмента, является смоленская компания Диолд. Электролобзики отличает низкая цена и довольно приличное качество. Для домашних работ это вполне подходящий бюджетный вариант.

Ремонт опорного ролика

В нем тоже есть моменты, которым стоит уделить внимание. Первое – это опорный ролик

Со временем, а это примерно год, он начинает терять круглую форму. Причина – материал ролика или технология его изготовления. Он обладает недостаточной твердостью.

Его ремонт заключается в замене. Все же лучше не изобретать велосипед, а приобрести оригинальный ролик от производителя или отнести инструмент в сервисный центр, особенно если он на гарантии.

Если такой вариант не подходит или невыполним, то можно реанимировать лобзик при помощи подручных средств. Для этого понадобится обычный болт М5 с гайкой. В данном случае болт будет служить осью, поэтому на нем нужно сточить резьбу, а гайка роликом, в ней по образующей необходимо прорезать паз по толщине пильного полотна.

Идеально это делать на токарном станке, но можно использовать и инструмент, который есть под рукой, например, дрель и диск угловой шлифмашинки. Диск нужно зажать в тиски, болт с гайкой – в дрель и нарезать паз. Вариант ремонта не идеальный, но имеет право на жизнь, так как проверен на практике.

Обслуживание пусковой кнопки

Еще один нюанс в использовании электролобзика Диолд – попадание древесной пыли в кнопку пуска. Происходит это по причине отсутствия герметичности, и пыль, попадая внутрь кнопки, препятствует прохождению тока. Решением проблемы будет периодическая, не реже одного раза в год, чистка контактов.

Рекомендации и правила как пилить лобзиком ровно

На основании продолжительного применения рассматриваемого инструмента, были собраны отзывы мастеров и специалистов, которые призваны помочь начинающим пильщикам в эксплуатации электролобзиков. Чтобы научиться пилить ровно без искажений, зазубрин и прочих дефектов, следует придерживаться следующих советов и рекомендаций:

- Правильно выбирать полотна для материала в зависимости от его толщины

- Полотна бывают разной толщины, и для максимально ровного и качественного распила необходимо выбирать тонкие пилки. При этом учитывайте, что толщина пилки должна соответствовать твердости и прочности распиливаемой заготовки

- Распиливаемую заготовку необходимо хорошо закрепить, исключив возникновение ее вибраций при проведении работ

- Обязательно пользоваться карандашами и маркерами, осуществляя нанесение разметки. Чем точнее будет нанесена разметка, тем выше эффективность выполнения ровного распила лобзиком

- Проверить инструмент перед работой. При малейших подозрениях на неисправности, рекомендуется опробовать его на непригодном материале

- Использовать направляющие, посредством которых повышается эффективность проведения работ по прямому распиливанию заготовок

- Использовать пылесос, который будет не только удалять опилки с линии реза, но и повышать видимость линии разметки

- На некоторых моделях лобзиков имеются специальные лазерные лучи в виде линии. Чтобы не контролировать движения полотна, следует ориентироваться на линию лазера, что позволит получить максимально-ровный распил даже без необходимости использования направляющих

- Не торопиться перемещать и толкать инструмент. Скорость должна быть оптимальной, как и установленное количество возвратно-поступательных движений штока

- Проверить качество заточки зубьев, и в противном случае, использовать новое полотно

Электрообзиком называется универсальный инструмент, который нашел свое применение не только в строительстве и ремонте, но и домашнем хозяйстве. Этот инструмент имеет аналоги, как болгарка и дисковая пила, однако каждый электроинструмент имеет свое назначение, к примеру, УШМ нельзя произвести прямой распил с точным соблюдением угла наклона.

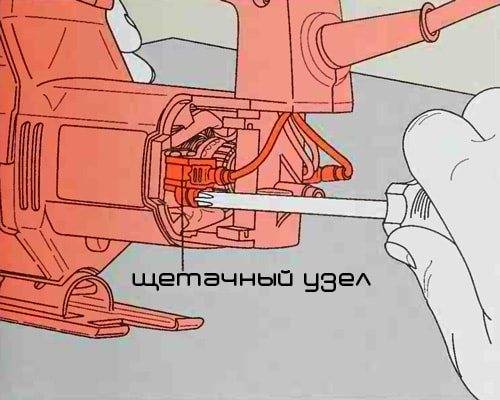

Как выявить неисправность щеточного узла

Из строя на дрели выходят щетки, которые являются расходным элементом. Щетки изготавливаются из графита, и с их помощью происходит передача тока на ротор через коллекторный узел. В процессе работы щетки истираются, выгорают, изнашиваются и требуют замены. Ресурс щеток зависит от разных факторов:

- Качество

- Исправность коллектора

- Нагрузка электроинструмента

Выявить неисправность щеток можно по такому признаку, как избыточное искрение. Если до того, как дрель перестала запускаться, наблюдалась ее чрезмерное искрение с признаками возникновения нагара, то с высокой долей вероятности необходимо заменить угольные щетки. Для замены необходимо извлечь элементы из щеткодержателей, вытащить изношенные части и установить на их место новые.

Это интересно! Если износ щеток более 60% от изначальной длины, то их необходимо заменить.

Кроме неисправности щеток, необходимо обратить внимание на состояние медных ламелей коллектора. Если на медной основе наблюдаются признаки нагара, а также сколы и прочие дефекты, то все это следует устранить

Если устранить не получается самостоятельно, тогда следует заменить якорь. Причинами возникновения нагара на медных пластинах является избыточное искрение электроинструмента. Кроме того, при сильном износе коллектора возникает соединение (замыкание) пластин между собой, что также недопустимо.

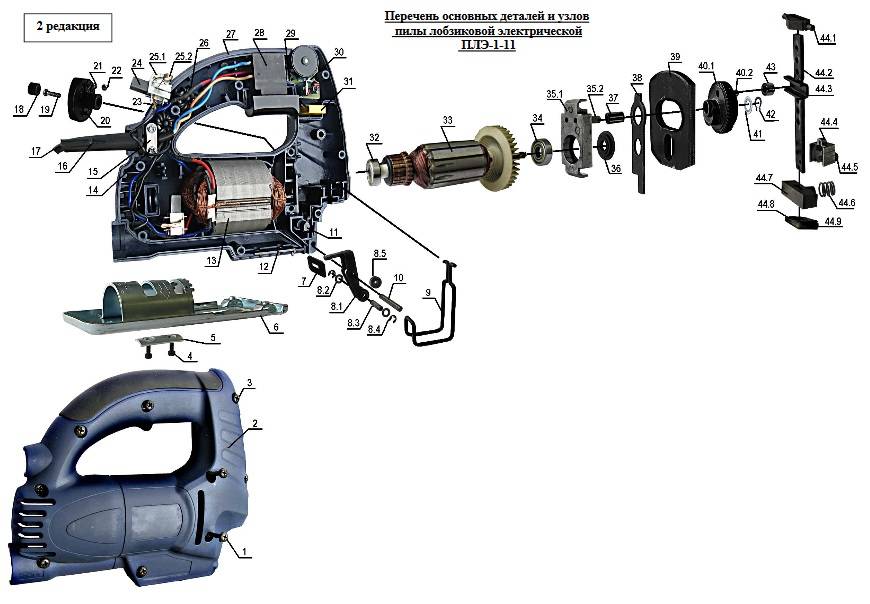

Как устроен электрический лобзик и принцип его работы

В процессе эксплуатации любого вида инструмента, возникают разные неисправности. Причины их появления разные, а для устранения необходимо знать внутреннюю конструкцию лобзика, а также принцип работы. Прибор относится к категории электроинструментов, поэтому суть его работы заключается в превращении электрической энергии в полезную механическую силу.

Работая инструментом, мало кто задумывается над тем, как он устроен внутри. Лишь при возникновении первых признаков неисправной работы прибора, возникает необходимость его разборки и изучения конструкции. После разборки можно столкнуться с массой вопросов о том, какие функции выполняет каждая деталь и механизм внутри прибора. Хотя его конструкция состоит из многих деталей, однако принцип работы довольно простой и незамысловатый. Перед тем, как ремонтировать лобзик своими руками, следует разобраться с его составными деталями и принципом их работы.

Любая модель электрического лобзика состоит из следующих основных частей:

- Электродвигатель щеточного или коллекторного типа — приводной механизм, посредством которого в действие приводится исполнительный орган, то есть, шток

- Редуктор — это передаточное звено, обеспечивающее связь электродвигателя с штоком инструмента

- Шток — это исполнительный орган прибора, который приводится в движение посредством редукторного узла. В штоке крепится насадка, то есть полотно для распиливания материала

Это основные механизмы, из которых состоит инструмент. Кроме главных элементов, в конструкции также применяются:

- Вентилятор охлаждения электродвигателя, который крепится на валу ротора

- Регулятор скорости, позволяющий изменять частоту маятниковых действий режущего полотна, закрепленного в шпинделе штока

- Кнопка запуска прибора — размещается в конструкции рукоятки, и большинство моделей имеют встроенные регуляторы в этой детали

В конструкции оборудования нет ничего сверхъестественного, а принцип работы электрических агрегатов основывается на трансформации электрической энергии в механическую. На статор и ротор двигателя подается ток. На вращающийся статор подача электроэнергии осуществляется посредством графитовых щеток. Ток в обмотке статора заставляет вращаться ротор, тем самым в движение приводится вал, развивая угловую скорость.

Назначение редуктора заключается в том, чтобы превращать крутящий момент из вращательных действий в возвратно-поступательные движения. Кроме того, на редуктор также возложена опция понижения скорости, так как ротор крутится с большой скоростью, и если бы с такой частотой двигалась насадка в приборе, то она быстро бы выходила из строя без возможности достижения результатов. Редуктор состоит из шестерней, посредством которых и обеспечивается передача вращательных движений.

Возвратно-поступательные движения от редуктора подаются на шток, который является направляющим для режущих элементов. Полотно крепится в шпинделе или патроне инструмента, обеспечивая надежную фиксацию режущих насадок. В итоге насадка в виде режущего полотна приводится в движение, осуществляя распиливание материала.

Это интересно! Имея представление о том, как работает электролобзик, не составит большого труда выявить и устранить поломку деталей и механизмов инструмента. Самостоятельный ремонт лобзика начинается с того, что предварительно следует отыскать место поломки, и только после этого приступать к устранению дефекта (для этого обычно неисправный узел меняется на новый).

Особенности конструкции

Электродрель представляет собой пластиковый корпус (иногда металлический), а также рабочую область, представленную в виде патрона для закрепления соответствующих насадок для выполнения различных работ. В корпусе электродрели находятся как электрические, так и механические части.

В устройство электрической части входят такие составляющие:

- Электродвигатель переменного тока двухфазный.

- Контактные щетки, располагающиеся в щеткодержателе.

- Кнопка пуска электроинструмента.

- Кабель электропитания.

- Регулятор оборотов.

- Механизм переключения направления вращения патрона.

- Пусковой конденсатор.

Устройство механической части представлено в виде редуктора и системы подшипников. Главная функция редуктора (набор шестеренок) заключается в передаче крутящего момента с вала электродвигателя на патрон инструмента. В ударных дрелях и перфораторах механическая часть дополнительно представлена двумя поршнями, а также тараном и бойком. Эти элементы позволяют включать ударный режим, то есть функцию отбойного молотка. Конструкция инструмента вовсе не сложная, поэтому устранить возникающие поломки сможет даже малоопытный специалист. Прежде чем приступать к устранению поломки, следует обнаружить причину, а для этого необходимо разобрать инструмент.

Необходимые инструменты и материалы

Чтобы провести ремонт дрели своими руками, понадобится воспользоваться такими инструментами:

- отвертки, чтобы разобрать инструмент;

- мультиметр, для определения неисправностей в электрической части;

- наждачная бумага, чтобы выполнить зачистку окислившихся контактов.

В зависимости от причин поломки, потребуются также некоторые материалы. К таковым относятся:

- шестеренки;

- щетки;

- подшипники;

- кнопка.

Кроме того, если инструмент давно не разбирался, то желательно при разборке заодно поменять смазку в редукторе. Это снизит нагрузку на электродвигатель, а также позволит продлить срок службы инструмента. В смазке также нуждаются и подшипники, поэтому независимо от причин неисправности инструмента, после их устранения обязательно нужно уделить время диагностике.

Механические неисправности

Ремонт дрели своими руками начинается с определения причин неисправности инструмента. Для начала нужно выявить, какая часть инструмента дала сбой: электрическая или механическая. Как правило, сделать это не составляет особого труда. К основным неполадкам механической части относятся:

- Неисправность подшипников.

- Поломка редуктора.

- Выход из строя редуктора.

Неполадки механики определяются достаточно легко, так как при этом будет слышен звук работающего электромотора. Если не исправен редуктор или подшипник, то будет возникать характерный звук. Если неисправен патрон, то мастер при этом не сможет зажать в нем рабочий элемент.

- Неисправны подшипники. Выйти из строя подшипники могут, только если в смазку попадет пыль, или от непомерных нагрузок. Если подшипник не рассыпался, то устранить поломку не составит труда. Для этого нужно разобрать инструмент, промыть подшипник керосином, после чего набить его смазочным материалом. После этого не забудьте заменить сальники, так как, скорее всего, именно из-за них пыль попала внутрь инструмента. Подшипники лучше смазывать специальными смазками для высокооборотистых устройств.

- Неполадки в редукторе устраняются только путем замены шестерней. Как правило, осуществляется замена целого механизма, так как найти отдельно какую-либо запчасть почти нереально. Приобрести сам редуктор для дрели можно в случае, если ваша дрель имеет известное имя. Если дрель неизвестного или китайского производства, то что-либо из запчастей найти на нее практически нереально.

- Поломка патрона. Если на инструменте установлен ключевой патрон, то такие изделия выходят из строя очень редко. Но если такое случилось, то необходимо заменить устройство целиком. В некоторых случаях в патроне может заклинить одна губка, поэтому для устранения неисправности, изделие необходимо разобрать и почистить. Быстрозажимные патроны выходят из строя чаще, поэтому их следует заменить на новый после поломки или при ослабевании зажима.

Зачастую в механической части из строя выходят подшипники или система редуктора, реже патрон. Для устранения неисправности патрона, нет необходимости в разборке инструмента. В любом случае, провести ремонт механики дрели намного дешевле, нежели прибегать к приобретению нового инструмента.

Неполадки в электрической части

Неполадки двигателя и компонентов электросистемы лобзика вызывают самые разные последствия. Есть перечень типовых неисправностей.

Искрят щетки

Графитовые щетки, передающие напряжение на ротор двигателя, подвержены износу. Это плановое явление. Поэтому при появлении искр в корпусе инструмента, неполной отдаче мощности, достаточно заменить пару щеток. Большинство электролобзиков оснащено узлами для их быстрой установки.

Графитовые щетки со временем изнашиваются и нуждаются в замене

Плавающие обороты

Если лобзик даже на холостом ходу не поддерживает стабильных оборотов, кратковременно прекращает работу при изменении положения корпуса, стоит исследовать все точки крепления проводов и их целостность. Особенно, если подобные неполадки в работе инструмента сопровождаются запахом гари

Для этого открывают корпус и внимательно осматривают проводку, обращая особое внимание на точки подключения двигателя и пусковой кнопки

Для проверки проводов следует вскрыть корпус инструмента

Пила останавливается под нагрузкой

Причиной останова ротора двигателя под нагрузкой является частичное повреждение его обмоток. Чаще всего это межвитковое замыкание. В этом случае двигатель сильно греется. Ремонт при подобной неисправности достаточно сложен. Это может быть перемотка двигателя или полная замена мотора на новый с правильным его подключением. Определить межвитковые замыкания измерением сопротивления обмоток поможет мультиметр.

Определить межвитковое замыкание можно при помощи мультиметра

Наконец, нельзя не упомянуть неисправность, указанную во всех инструкциях по эксплуатации электролобзика: инструмент не включается. В этом случае рекомендуется проверить правильность напряжения в розетке и целостность питающего кабеля. И сделать ту же работу, что и при возникновении плавающих оборотов двигателя. Если принятые меры не помогают, понадобится помощь квалифицированного мастера.

Замена штока

Рисунок 5 – Шток Шток лобзика — это деталь, к которой крепится пилка.

Во время работы он совершает возвратно-поступательные движения, испытывая максимальную нагрузку.

Для ремонта электролобзика своими руками потребуется извлечь неисправный шток, разобрав лобзик (снять переднюю крышку или боковую, если корпус состоит только из двух половин).

Надо извлечь неисправный шток и установить на его место новый элемент, следя за положением металлических деталей.

Перед извлечением следует внимательно осмотреть положение штока, запомнить, какие элементы входят в соприкосновение или взаимодействие, чтобы при установке нового штока ничего не изменить. Установленную деталь надо обильно смазать литолом, чтобы снизить износ и продлить ресурс.

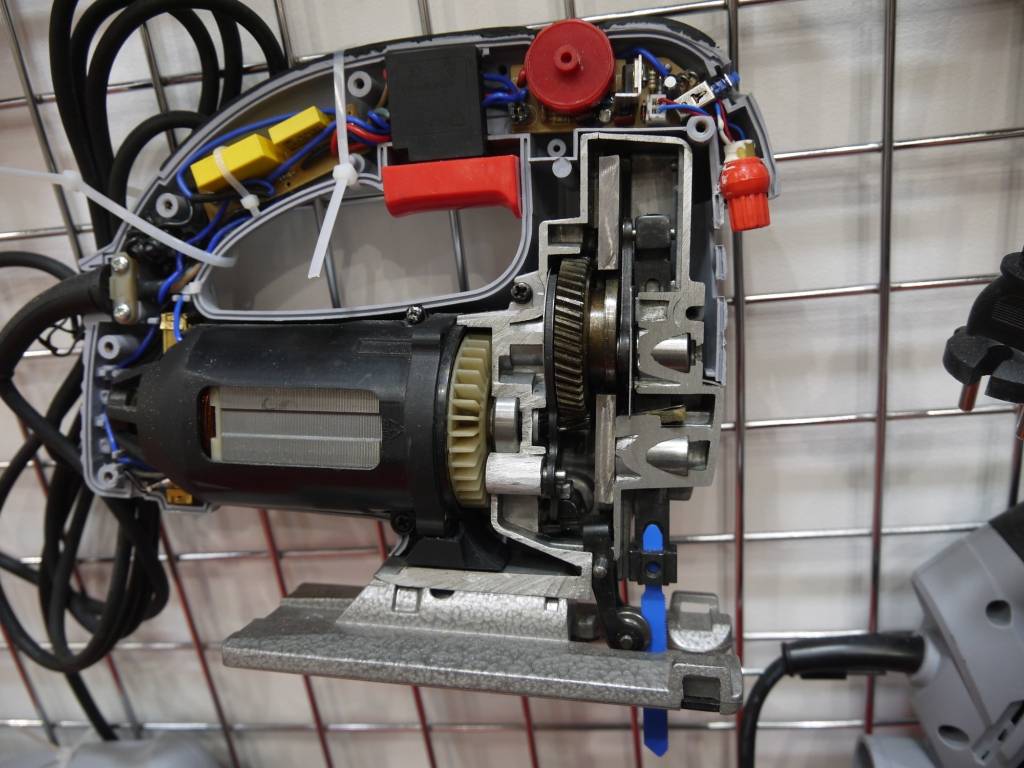

Как это работает

Принцип работы электролобзика достаточно прост. Задача его главного маятникового механизма заключается в преобразовании вращения вала электродвигателя в поступательно-возвратное движение штока, на котором закреплена пила. Устройство состоит из следующих важных компонентов.

- Система управления электродвигателем. В самом простом случае состоит из комбинированной пусковой кнопки. У нее есть устройство фиксации и регулятор оборотов. Последний может быть реализован как встроенный или внешний.

- Электродвигатель. Это основной компонент, преобразующий электрическую энергию в механическую.

- Блок вентиляции. Обычно выполняется в виде лопастной втулки, установленной на валу мотора.

- Червячный узел. Представляет собой втулку со спиральными выступами на валу электродвигателя и шестеренчатое колесо маятникового механизма.

- Маятниковый механизм. Его конструкционное решение может быть как кардинально простым, так и с повышенным ресурсом в дорогом инструменте.

- Шток, двигающийся вертикально, с устройством фиксации пилы на одном из концов.

- Вспомогательные направляющие узлы. Это опорный ролик пилы, система маятникового движения, основание инструмента, позволяющее устанавливать наклон реза.

Типовое устройство электролобзика

Несмотря на кажущуюся сложность, все работает достаточно просто. При пуске двигатель начинает вращение. Втулка на его валу, часть червячного узла, передает усилие на шестерню маятникового механизма. Последний вращается с гораздо меньшей скоростью относительно двигателя. Но в таком же соотношении с большим моментом силы.

Маятник также достаточно прост для понимания. В общем случае, это соосные шестерня привода и пластина взаимодействия со штоком. В самой простой конфигурации у последней есть две ключевые точки. Это ось вращения и место крепления шатуна, отстоящее от нее по вертикали на половину показателя хода пилы инструмента.

Шток приводится в поступательно-возвратное движение следующим образом: вращаясь, пластина маятника перемещает вторую ключевую точку. Это происходит в двух направлениях, горизонтали и вертикали. С помощью шатуна, металлической пластины, усилие передается на шток. Последний может двигаться только по вертикали между горизонтальными ограничителями.

Резка ламината электролобзиком

Общая механика работы электролобзиком проста. Оператор направляет пильное полотно по линии будущего реза. Чтобы гарантировать ему точность работы, пила фиксируется по горизонтали при помощи опорного ролика. В нем есть углубление, по которому вертикально перемещается режущий инструмент.

Выводы если лобзик пилит криво что можно сделать

Однозначно инструмент должен выполнять прямой и ровный распил, и если рез получается кривым с задирами, то это считается дефектом работы. Причем дефект может быть связан как с неисправностью инструмента, так и отсутствием опыта у мастера. Чтобы пилить инструментом ровно, следует проверить лобзик на пригодность и отсутствие дефектов (при необходимости устранить их или отрегулировать), а также убедиться в правильности управления прибором.

Публикации по теме

Аккумуляторная болгарка назначение инструмента

Низкооборотистая дрель и ее предназначение

Как выполняется ремонт шуруповерта без помощи специалиста

Паяльник для пайки проводов и микросхем — виды и как правильно пользоваться инструментом